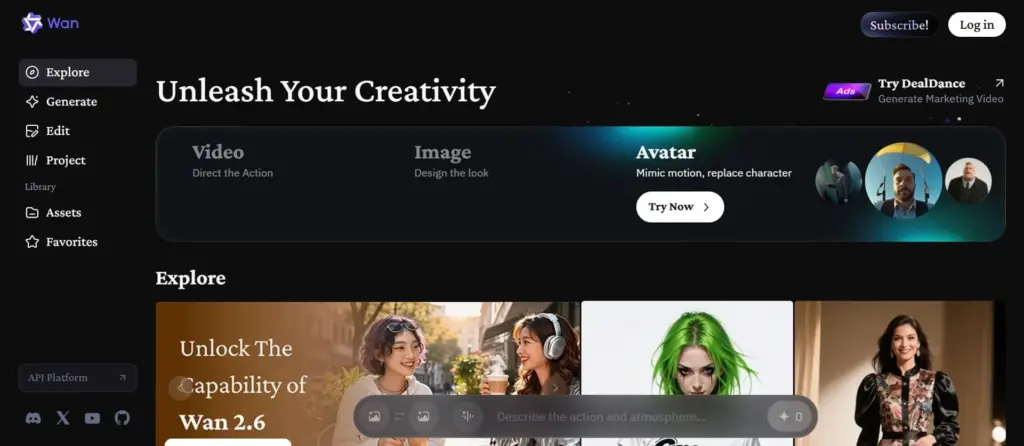

Wan AI нейросеть: экспертный обзор возможностей и технологий

Wan Video — это нейросеть из Китая, которая умеет делать видео и анимацию. Она входит в семейство Alibaba Cloud. В Wan можно вводить текст, описывать сцену и получать готовое видео, а можно брать обычное фото и анимировать его. Видео получается плавным, кадры сменяются логично. Это удобно для креаторов, инди-режиссеров, маркетологов и видеоблогеров, которые хотят делать контент на ПК или через онлайн-сервисы.

Сегодня самой актуальной версией является Wan 2.6, у нее есть кинематографический режим Multi-shot и улучшена работа с текстовыми промптами. Наиболее актуальными версиями для локального запуска Wan Video AI являются модели Wan 2.1, 2.2. Эти нейросети стали лидером индустрии для создания ИИ-видео по тексту и изображениям благодаря открытому исходному коду и высокой физической точности движений.

Ключевые возможности Wan AI

Text-to-Video

Wan AI умеет создавать видео по тексту. Вы описываете, что происходит, какой свет, стиль и ракурс, а нейросеть собирает кадры в готовый ролик. Видео получается плавным, сцены связаны между собой, так что это удобно для коротких вертикальных клипов, презентаций или рекламы.

Image-to-Video

Вы можете взять обычное фото и превратить его в анимацию. Модель следит за деталями и плавностью движения. Это удобно, если хотите показать продукт, оживить персонажа или визуализировать идею.

Стили

Нейросеть поддерживает разные стили — от реалистичных сцен до мультяшной 2D и 3D анимации. Вы можете создавать фотореалистичные кадры, мультяшные ролики или добавлять кинематографические эффекты и анимацию персонажей.

Длительность, частота кадров и разрешение

В Wan AI вы можете выбирать длительность ролика, частоту кадров, соотношение сторон и разрешение. В версиях до 2.5 максимум — 1080p, а в 2.6 есть апскейл до 4K. Так видео легко адаптировать под разные платформы и форматы.

Технические характеристики семейства моделей Wan AI

| Версия | Период выхода | Ключевая особенность | Макс. разрешение | Доступность | Как пользоваться |

|---|---|---|---|---|---|

| Wan 2.1 | Февраль 2025 | Первый мощный Open Source ответ Sora. Появление моделей 1.3B и 14B | 720p / 1080p | Открытые веса, Hugging Face | Можно скачать бесплатно на свой ПК. Работает в программах типа ComfyUI или Forge |

| Wan 2.2 | Май 2025 | Оптимизация архитектуры (MoE). Появление функции «First-Last Frame» | 1080p | Открытые веса, ComfyUI | Есть на Hugging Face (для скачивания) и на Replicate/Fal.ai (платная аренда мощностей) |

| Wan 2.5 | Сентябрь 2025 | Интеграция Virtual Try-On и продвинутый физический движок | 1080p (HQ) | API, Веса моделей | Можно встроить в свои приложения через код или использовать через официальный сайт разработчика по подписке |

| Wan 2.6 | Декабрь 2025 | Кинематографический режим (Multi-shot) и улучшенная работа с текстом | 4K (апскейл) | Ранний доступ / API | Пока нельзя скачать на ПК. Доступна только через онлайн-сервисы разработчика (платные лимиты) |

Глоссарий

Для полного понимания технических терминов из таблицы — словарь:

- Открытые веса (Open Weights) — это «мозги» нейросети в виде файлов (часто форматов .safetensors или .ckpt). Вы скачиваете их один раз (они могут весить от 10 до 80 Гб), и дальше нейросеть работает без интернета. Вы платите только за электричество, которое потребляет ваша видеокарта.

- Hugging Face — это «GitHub для нейросетей». Главный сайт в мире, откуда все качают модели, веса и смотрят демо-версии. Если в статье есть ссылка на Hugging Face — значит, модель можно забрать себе.

- API (Application Programming Interface) — способ использования через «облако». Вы пишете текст в окошке на сайте (или через специальный код), а видео рендерится на серверах компании Alibaba. Это платно, но зато не нужен дорогой компьютер.

- ComfyUI / Forge — это бесплатные оболочки (интерфейсы) для запуска моделей с «открытыми весами» на вашем компьютере. Они выглядят как конструкторы из блоков или простые панели управления.

Что нужно для запуска?

Для того чтобы запустить Wan AI со своего ПК, вам понадобится видеокарта серии NVIDIA RTX:

- Для версии 1.3B (быстрая/базовая): минимум 8–12 ГБ видеопамяти (уровня RTX 3060/4060).

- Для версии 14B (максимальное качество): минимум 24 ГБ видеопамяти (уровня RTX 3090/4090).

Если ваше железо слабее, используйте облачные сервисы:

- Hugging Face Spaces (бесплатно): главная «песочница» для всех нейросетей. Разработчики выкладывают здесь официальные демо-версии.

- Fal.ai: один из самых быстрых облачных сервисов для разработчиков, который сделал удобный интерфейс для обычных людей.

- Replicate: похожий на Fal сервис, где можно протестировать разные версии модели (включая облегченную 1.3B и тяжелую 14B).

4. Главная ценность Wan AI

Нейросеть Wan AI имеет отличие от конкурентов Sora, Runway, Kling — она предоставляет свободу. Пока другие закрывают свои технологии за платными подписками и строгими фильтрами, Wan дает пользователям возможность создавать контент профессионального уровня на своем железе.

- Свобода использования и локальный запуск на ПК с открытыми весами.

- Поддержка Text-to-Video и Image-to-Video, разнообразие визуальных стилей.

- Возможность генерации видео до 4K с кинематографическим качеством.

- Подходит как для профессионалов, так и для инди-проектов.

- Новейшие функции (4K Multi-shot, улучшенная работа с текстом) доступны только онлайн.

- Требуются мощные видеокарты для тяжелых моделей (14B).

5. Лайфхак для лучшего результата

Как генерировать видео в Wan на ПК? 3 совета по составлению промпта для Wan AI, чтобы нейросеть даже первые тесты выдала удачными:

- Описывайте движение: используйте глаголы. Не просто «Кошка», а «Кошка медленно поворачивает голову и подмигивает, камера плавно приближается».

- Стиль прежде всего: указывайте качество. Добавляйте фразы: «Cinematic lighting, 8k resolution, highly detailed skin texture, masterpiece».

- Используйте Image-to-Video: Wan AI работает гораздо стабильнее, если дать ей готовую картинку и попросить её «оживить», чем генерировать всё с нуля из текста.

Пример промпта для Wan Video

A serene lakeside at dawn, mist rising from the water, pine trees reflected in the glassy surface, a lone loon glides silently across the frame, cinematic 4K, soft golden light, ultra-realistic nature documentary style.

Русский перевод:

«Спокойное озеро на рассвете: над водой поднимается туман, сосны отражаются в зеркальной глади, одинокий гагара бесшумно скользит по кадру, кинематографическое качество 4K, мягкий золотистый свет, сверхреалистичный стиль натурфильма.»

Этот промпт показывает, как Wan Video справляется с атмосферой, плавным движением и детализацией природы. Чёткие визуальные дескрипторы (mist, glassy surface, golden light) и стилевая привязка (nature documentary) помогают модели сгенерировать видео с высокой когерентностью и эмоциональной глубиной.

Вердикт

Wan AI нейросеть подходит инди-режиссерам, маркетологам, видеоблогерам и креаторам, которым важны свобода и качество при генерации видеоконтента. Система позволяет создавать ролики на ПК через открытые веса или использовать облачные сервисы через API, поддерживая Text-to-Video, Image-to-Video и разнообразные визуальные стили. Перспективы развития включают интеграцию с другими ИИ-инструментами, расширение визуальных эффектов и увеличение длины видео без потери консистентности кадров в последних версиях. Это делает Wan AI удобным инструментом как для локального, так и для онлайн-видеогенератора профессионального уровня.

❓ Часто задаваемые вопросы

Ответы на актуальные вопросы об этом ИИ инструменте